Apple совместно с Колумбийским университетом разработала исследовательский проект SceneScout, предназначенный для навигационной помощи незрячим и слабовидящим людям. Технология объединяет картографический сервис Apple Maps с языковой моделью GPT-4o для преобразования визуальной информации в подробные голосовые описания окружающей среды.

Первые испытания с участием 10 человек с нарушениями зрения показали положительные результаты. Участники отметили высокую практическую ценность сервиса, особенно выделив режим Virtual Exploration.

Узнать подробнее про клуб ShareAI

Однако тестирование выявило и некоторые недостатки — в частности, случаи неточной маркировки дорожных знаков и устаревшие данные о временных изменениях городской инфраструктуры, включая строительные работы и паркинг.

Система предлагает пользователям два функциональных режима работы. Режим Route Preview предоставляет предварительный обзор маршрута с описанием препятствий на тротуарах, перекрестков и визуальных ориентиров.

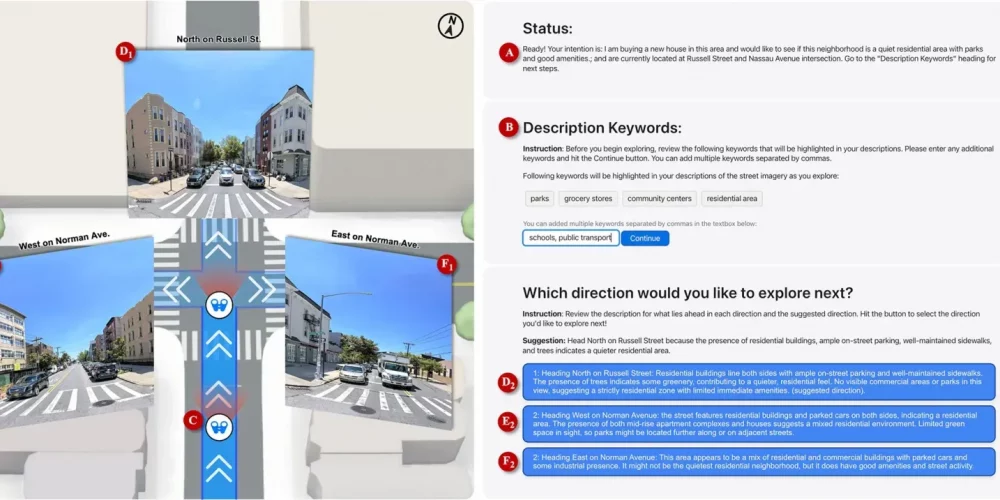

Второй режим — Virtual Exploration — позволяет пользователю сформулировать запрос на основе предпочтений (например, «тихий жилой район с парками»), после чего ИИ проводит пошаговую навигацию к подходящему месту.

Техническая реализация SceneScout основана на имитации поля зрения пешехода с использованием данных Apple Maps.

Система обрабатывает эту информацию и формирует структурированные текстовые описания с различной степенью детализации — короткие, средние или длинные, в зависимости от предпочтений пользователя.