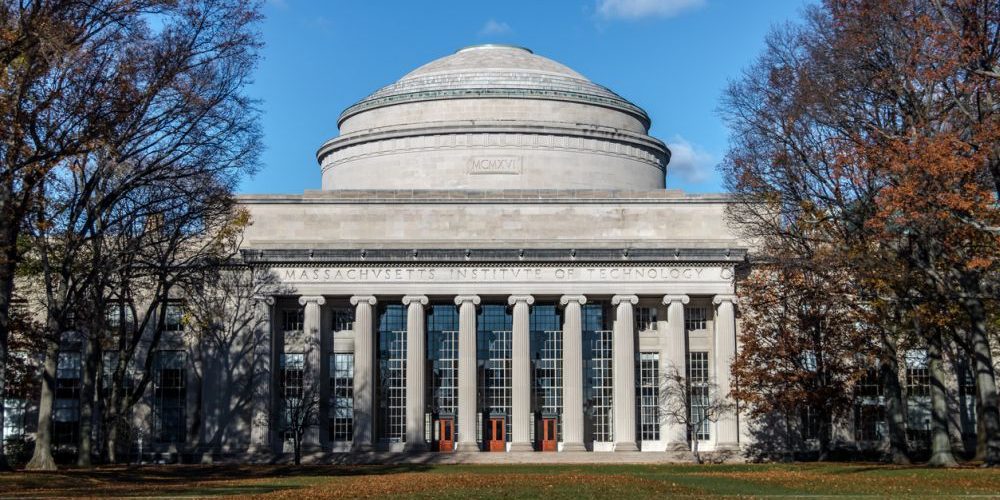

Исследователи из MIT и лаборатории MIT-IBM Watson AI разработали универсальное руководство по созданию законов масштабирования для больших языковых моделей (LLM). Их работа помогает разработчикам предсказывать эффективность крупных моделей на основе тестирования более мелких и менее затратных версий.

Учитывая, что разработка LLM может стоить миллионы долларов, эти прогнозы помогают оптимально распределить бюджет перед созданием полноценной модели. Законы масштабирования позволяют предсказать качество и точность крупной модели без необходимости ее полной тренировки.

Узнать подробнее про клуб ShareAI

Команда исследователей во главе с Джейкобом Андреасом, доцентом Массачусетского технологического института, собрала обширную базу данных из 485 уникальных предварительно обученных моделей из 40 различных семейств, включая Pythia, OPT, LLaMA, Bloom и GPT. На основе этих данных они создали и проанализировали более 1000 законов масштабирования.

«Идея создания математических моделей процесса обучения существует уже пару лет, но новизна нашей работы в том, что мы систематически проанализировали, как лучше использовать вычислительный бюджет при разработке новых крупномасштабных моделей», — отмечает Андреас.

В ходе исследования ученые выявили несколько ключевых факторов, повышающих точность прогнозов. Они рекомендуют включать в анализ промежуточные контрольные точки обучения, отбрасывать очень ранние данные тренировки (до 10 миллиардов токенов) и тренировать несколько моделей разного размера для повышения надежности прогноза.

Исследование показало, что точность предсказания до 4% — это лучший достижимый результат из-за случайных факторов, но даже точность до 20% остается полезной для принятия решений. Важным открытием стало то, что для создания надежного прогноза достаточно тренировать целевую модель лишь на 30% от запланированного объема данных.

Кроме того, исследователи обнаружили, что малые модели, частично обученные, все равно дают хорошие прогнозы, а промежуточные этапы обучения полностью обученной модели могут использоваться как отдельные модели для прогнозирования других целевых моделей.

«Если вы уже обучили полную модель, то получаете наполовину обученную модель просто как побочный продукт того, что вы сделали», — поясняет Лешем Чошен, один из авторов исследования.

В дальнейшем команда планирует расширить свой анализ на время вывода модели, что может стать еще более важным, поскольку для каждого нового запроса пользователя необходимо определять, насколько интенсивно должна «думать» модель для получения наилучшего ответа.

Исследование было частично поддержано лабораторией MIT-IBM Watson AI и стипендией Sloan Research Fellowship.