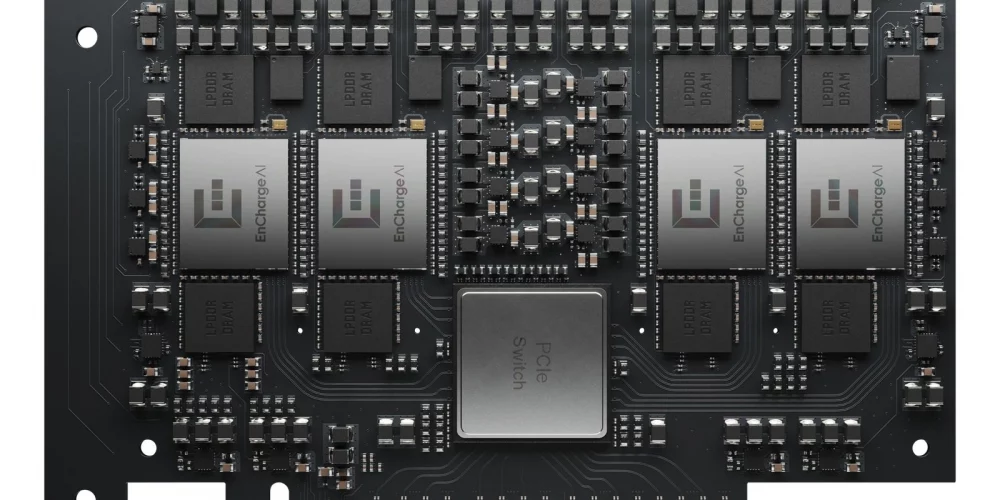

ИИ-стартап EnCharge AI представил рынку семейство аналоговых ИИ-ускорителей EN100, реализующих концепцию вычислений в оперативной памяти (in-memory computing). Линейка включает два форм-фактора: компактные модули M.2 для мобильных платформ и карты расширения PCIe HHHL для высокопроизводительных рабочих станций.

Технологическая архитектура решений базируется на принципиально новом подходе к организации вычислительных процессов, устраняющем традиционные ограничения, связанные с передачей данных между процессором и памятью. Инженеры EnCharge AI создали специализированные NPU-ядра, демонстрирующие энергоэффективность до 40 триллионов операций в секунду на ватт потребляемой энергии (40 Топс/Вт) при использовании 8-битной точности вычислений.

Узнать подробнее про клуб ShareAI

Мобильная версия EN100 в конструктивном исполнении M.2 2280 интегрирует 32 гигабайта высокоскоростной памяти с пропускной способностью 68 гигабайт в секунду. Суммарная производительность модуля превышает 200 триллионов операций в секунду при энергопотреблении, не выходящем за пределы 8,25 ватт. Управление вычислительными процессами реализовано на базе многопоточной RISC-V архитектуры, оптимизированной для оркестрации параллельных вычислительных задач.

Профессиональный сегмент представлен линейкой ускорителей в формате карт расширения PCIe HHHL, оснащенных значительно расширенным объемом памяти — 128 гигабайт с агрегированной пропускной способностью 272 гигабайта в секунду. Производительность флагманских решений достигает 1 петаоперации в секунду (1 Попс), что позволяет эффективно обрабатывать комплексные модели искусственного интеллекта локально, без необходимости обращения к облачным вычислительным ресурсам. Производственный процесс всей линейки EN100 базируется на 16-нанометровой CMOS-технологии.

Генеральный директор EnCharge AI Навин Верма акцентирует внимание на стратегической переориентации рынка ИИ-вычислений с облачной инфраструктуры на локальные вычислительные ресурсы. По его утверждению, представленные решения демонстрируют революционные показатели в ключевых параметрах: 20-кратное превосходство в энергоэффективности (Топс/Вт), 9-кратное увеличение плотности вычислений (Топс/мм²) и 10-кратное снижение совокупной стоимости владения (TCO) по сравнению с актуальными ускорителями машинного обучения.