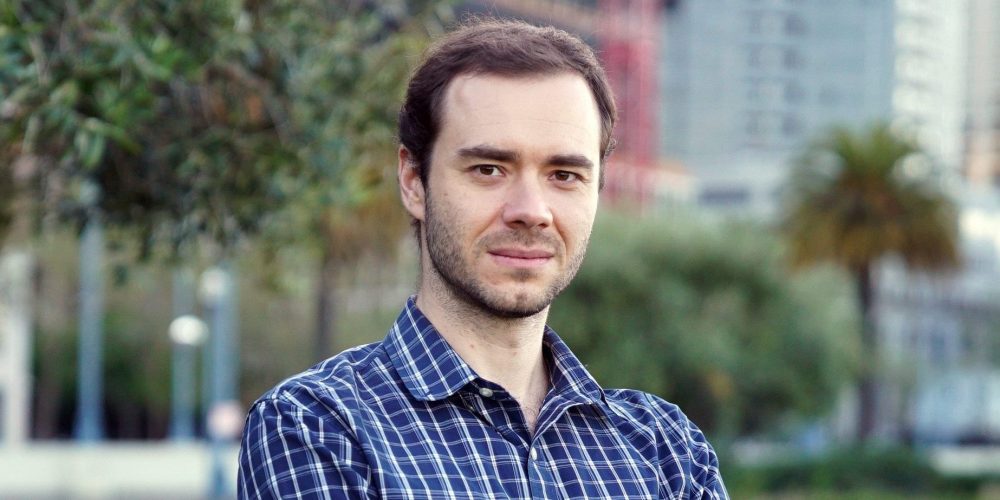

Бывший ведущий исследователь OpenAI и Tesla Андрей Карпатый, выступил с критикой метода reinforcement learning (RL) при обучении больших языковых моделей. Он назвал работу с RL-reward-функциями «излишне подозрительной».

По его мнению, такие функции ненадежны, легко поддаются манипуляциям и плохо подходят для развития сложных интеллектуальных навыков у искусственного интеллекта. Исследователь отмечает, что модели, обучаемые по этому принципу, достигли плато в своем развитии и для дальнейшего прогресса нужны новые подходы к обучению ИИ.

Узнать подробнее про клуб ShareAI

Это заявление особенно важно, так как многие современные модели, развивающие логическое мышление у ИИ, используют именно RL.

При этом Карпатый не отрицает полностью ценность RL. Он считает его лучше, чем классическое контролируемое обучение (supervised finetuning), и предполагает, что RL-файнтюнинг продолжат применять для улучшения поведения моделей.

По мнению ученого, настоящий прорыв произойдет, когда появятся более эффективные способы обучения.

Один из таких подходов, упомянутых им, — system prompt learning, где обучение происходит на уровне токенов и контекстов, а не весов модели, похоже на то, как мозг обрабатывает информацию во сне.